Suuri tieto on markkinointitermi, joka kattaa koko data mined ajatuksen lähteistä, kuten hakukoneista, päivittäistavarakaupan ostomalleista, joita seurataan pisteiden kautta jne. Nykyajan maailmassa Internetissä on niin paljon tietolähteitä, jotka useammin kuin mittakaavassa tekevät siitä käyttökelvottoman ilman, että käsittely ja käsittely käsittäisi uskomattoman määrän aikaa yhdeltä palvelimelta. Anna Apache Hadoop

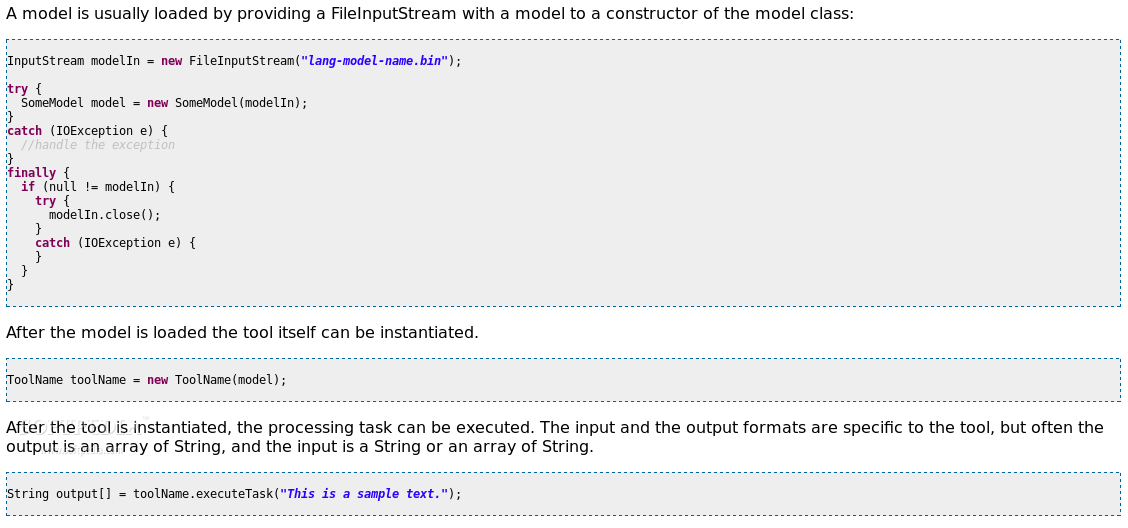

Vähemmän aikaa tietojenkäsittelyyn Hyödyntämällä Hadoop-arkkitehtuuria jakamalla käsittelytehtäviä useille koneille verkossa käsittelyajat vähenevät astronomisesti ja vastaukset voidaan määrittää kohtuullisessa määrin. Apache Hadoop on jaettu kahteen eri osaan: tallennuskomponenttiin ja käsittelykomponenttiin. Yksinkertaisimmillaan Hapood tekee yhdestä virtuaalisesta palvelimesta useista fyysisistä koneista . Itse asiassa Hadoop hoitaa useiden koneiden välisen tiedonsiirron niin, että ne toimivat yhdessä riittävän tarkasti, että näyttää siltä, että laskelmissa on vain yksi kone. Tietojen jakaminen useille koneille tallennetaan ja käsittelytoimet jaetaan ja koordinoi Hadoop-arkkitehtuuri . Tämän tyyppinen järjestelmä on vaatimus raakadatan muuntamisesta hyödyllisiksi tiedoiksi Big Data -tulojen mittakaavasta. Tarkastele tietoja, jotka Google vastaanottaa joka sekunnissa hakupyyntöjä lähettävistä käyttäjistä. Tietojen kokonaismäärästä et tiedä, mistä aloittaa, mutta Hadoop vähentää automaattisesti tietojoukkoja pienemmiksi, organisoituneiksi tietojenkoluiksi ja jakaa nämä hallittavat alijoukot tiettyihin resursseihin. Kaikki tulokset ilmoitetaan sitten takaisin ja kootaan käyttökelpoisiin tietoihin . Palvelin on helppo asettaa Vaikka järjestelmä kuulostaa monimutkaiselta, useimmat liikkuvista osista peittävät abstraktin taakse. Hadoop-palvelimen asentaminen on melko yksinkertaista , asenna palvelinkomponentit laitteistolle, joka täyttää järjestelmävaatimukset. Vaikeampi osa suunnittelee tietokoneiden verkon , että Hadoop-palvelin hyödyntää varastoinnin ja käsittelyn roolien jakamista. Tämä voi sisältää paikallisen verkon luomisen tai useiden verkkojen yhdistämisen Internetin välityksellä . Voit myös hyödyntää nykyisiä pilvipalveluja ja maksaa Hadoop-klusterin suosituille pilviympäristöille, kuten Microsoft Azure ja Amazon EC2. Nämä ovat entistäkin helpommin konfiguroitavissa, koska ne voivat siirtää ne ad hociksi ja purkaa sitten klusterit, kun niitä ei enää tarvita. Nämä klusterityypit ovat ihanteellisia testausta varten, koska maksat vain Hadoop-klusterin aktiivisen ajan. Tietojen käsitteleminen tarvittavien tietojen saamiseksi Suuria tietoja on erittäin voimakas resurssi, mutta tiedot ovat hyödyttömiä, ellei niitä voida luokitella asianmukaisesti ja muuttaa niistä. Tällä hetkellä Hadoop -klusterit tarjoavat erittäin kustannustehokkaan menetelmän näiden tietojen keräämistä varten.

Kommentteja ei löytynyt